Die Digitalisierung der Wissenschaft

Die Herausforderungen der digitalen Langzeitarchivierung stehen auf der Agenda der 7th International Conference on Preservation of Digital Objects (Ipres), die derzeit an der Technischen Universität Wien tagt. ORF.at sprach mit dem britischen Physiker und Informatiker Tony Hey über Chancen und Probleme zeitgenössischer datengetriebener Wissenschaft.

Tony Hey ist Professor für Computerwissenschaft an der University of Southampton und derzeit Vizepräsident für External Research bei Microsoft. Von 2001 bis 2005 war er Direktor des britischen Wissenschaftprogramms e-science.

ORF.at: Professor Hey, Ende 2009 haben Sie ein Buch mit dem Titel "The fourth Paradigm - Data-intensive scientific Discovery" herausgegeben. Was verstehen Sie unter dem vierten Paradigma?

Tony Hey: Der Begriff stammt eigentlich von Jim Gray, einem 2007 verstorbenen Kollegen bei Microsoft Research. Er bezog sich mit dem Schlagwort auf eine neue Art des wissenschaftlichen Arbeitens, das wir auch datenintensive Forschung nennen. Gemeint ist, dass wir es in den Natur- und teilweise auch in den Geisteswissenschaften immer häufiger mit von Sensoren und Computern erzeugten und verarbeiteten Daten zu tun haben. Das erste Paradigma bezeichnet die deskriptive und empirische Naturwissenschaft seit einigen Tausend Jahren. Das zweite Paradigma meint die theoretische Herangehensweise seit ein paar Hundert Jahren. Mit dem dritten sogenannten "computational" Paradigma bezeichnen wir den Umstand, dass in den Wissenschaften seit 50 Jahren Computer eingesetzt werden, um Simulationen durchzuführen, von Klimamodellen bis hin zur Berechnung einer Galaxieformation. Auf andere Weise kann man das nicht erforschen.

ORF.at: Welche Beispiele hätten Sie für diese datenintensive Wissenschaft?

Tony Hey: Bei Microsoft Research arbeiten wir derzeit unter anderem mit Medizinern zusammen. Beispielsweise ist es deshalb so schwer, gegen das HI-Virus einen Impfstoff zu entwickeln, da er sehr schnell und unvorhersehbar mutiert. Zu dem Zeitpunkt, an dem ein Arzneimittel fertig entwickelt wäre, ist das Virus längst wieder mutiert und die Impfung wirkungslos. Durch maschinelles Lernen aus der Informationswissenschaft konnten wir Schwachpunkte des Virus ausfindig machen. Wenn man das menschliche Immunsystem nun darauf trainieren könnte, das Virus an diesen Stellen anzugreifen, dann hat man eine Chance, einen wirksamen Impfstoff zu entwickeln.

ORF.at: Und außerhalb von Microsoft Research?

Tony Hey: Seit dem Jahr 2000 führt der sogenannte "Sloan Digital Sky Survey" eine automatisierte Durchmusterung von Teilen des Himmels durch Aufnahmen bei fünf Wellenlängen und nachfolgender Spektroskopie einzelner Objekte durch. Mit 100 TB an Daten wurden in den ersten Tagen des Projekts mehr Daten gesammelt als in der gesamten vorhergehenden Geschichte der Astronomie. So ein Projekt verändert die Art, wie wir Wissenschaft verstehen und betreiben. Es gibt nur rund 10.000 professionelle Astronomen auf der Erde. Allein könnten sie nie und nimmer diese gewaltigen Datenmassen bearbeiten. Deshalb werden die Daten publiziert, so kann auch die interessierte Öffentlichkeit bei den Forschungen mitarbeiten. Auf diese Weise ist schon eine Reihe von interessanten Entdeckungen gemacht worden.

ORF.at: Was sind denn die Probleme, die mit dieser Datenflut einhergehen?

Tony Hey: Eine der großen Herausforderungen besteht in der Dokumentation der Herkunft der Daten. Ein Beispiel: Die Stadt Seattle, wo ich derzeit lebe, befindet sich in einer Zone, die stark erdbebengefährdet ist, da dort zwei Kontinentalplatten aufeinanderstoßen. Man hat dort in den letzten Jahren am Meeresboden ein Sensornetzwerk aufgebaut, das ununterbrochen aktuelle Daten über die Aktivität der Erdplatten liefert. Es genügt aber nicht, dass man diese Daten sammelt. Man muss die Sensoren auch kalibrieren und das Rauschen reduzieren, also die Informationen so aufbereiten, dass sie für Wissenschaftler nutzvoll sind. Das bedeutet auch, dass man zusätzlich Metadaten speichern muss: Woher kommen die Daten, was wurde daran verändert, mit welchem Messinstrument wurden sie aufgenommen? Das heißt, man muss zu den eigentlichen Daten eine Menge zusätzlicher Informationen liefern und verwalten.

ORF.at: Wie sind denn traditionelle Institutionen wie Bibliotheken und wissenschaftliche Archive auf diese neue Art der Wissenschaft vorbereitet?

Tony Hey: Ich bin davon überzeugt, dass sich die Rolle von Fach- oder Universitätsbibliotheken in nächster Zeit sehr stark ändern wird. Als Professor und Dekan an der Universität in Southampton ist mir aufgefallen, dass meine Studenten kaum mehr in die Bibliothek gingen, um an Bücher oder wissenschaftliche Publikationen heranzukommen. Sie nutzten den Ort, um dort Freunde zu treffen und zu arbeiten, weil es dort Kaffee und WLAN gab. Aber streng genommen braucht es für diese Dienste keine Bibliothek. Was ist also heute, in einer Zeit, in der man in eine Suchmaschine ein paar Schlagwörter eingeben kann und sehr viele gute Ergebnisse bekommt, die Rolle einer Bibliothek? Universitätsbibliotheken sind heute zwar nicht obsolet, aber sie müssen andere Aufgaben übernehmen. Universitäten erhalten ihre Reputation unter anderem dadurch, wie oft Arbeiten ihrer Wissenschaftler zitiert oder auf sie verlinkt wird. Die Bibliotheken sollten sich stärker darauf konzentrieren, Inhalte, die vom wissenschaftlichen Personal erstellt werden - seien es fertige Aufsätze oder Datensammlungen -, zu sammeln und zugänglich zu machen.

ORF.at: Sie beschäftigen sich auch mit den Herausforderungen der Langzeitarchivierung von digitalen Daten. Warum ist es denn so wichtig, dass auf diesem Gebiet Forschung und Aufklärung passiert?

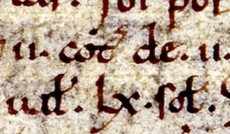

Tony Hey: Eines der ältesten und wichtigsten Dokumente Großbritanniens ist das Domesday Book. Es ist eine Art Grundbuch und Volkszählung, das nach der Eroberung Englands durch William the Conqueror angelegt wurde. Es ist im National Archive gelagert und man kann noch immer darin lesen. In den 1980er Jahren wollte man zum Jahrestag eine digitale Version des Domesday Books erzeugen. Man investierte sehr viel Zeit und Mühe in die Übersetzung der Originalseiten in eine digitale Version. Mit zusätzlichen Statements von Wissenschaftlern und Journalisten fügte man alles in eine Videoversion zusammen. Man war damals wirklich modern und up to date und hat eine zeitgenössische Technologie namens Laserdisc, eine Vorgängerin der DVD, verwendet. Der damals gebräuchliche BBC-Microcomputer konnte die Disc mit einem zusätzlichen Player abspielen. Ein wundervolles Projekt, nur 20 Jahre später gab es im ganzen Land nur mehr zwei Geräte, die diese Disc lesen konnten. Der BBC-Microcomputer war nicht mehr erhältlich und das Format komplett veraltet. Es war dann sehr kompliziert und teuer, diese veralteten digitalen Daten in kompatible Dateiformate zu konvertieren. Das war eine ziemliche Niederlage für die Computerwissenschaften und sollte nie wieder vorkommen.

(Anna Masoner)